Jog és az AI találkozása: felelősség, kockázat, szabályozás

![]() Dr. Kerecsen Éva

Dr. Kerecsen Éva

![]() 2025.08.14

2025.08.14

Jog, felelősség és a mesterséges intelligencia határterületei

A mesterséges intelligencia mára átlépte a sci-fi határait: nemcsak gépkocsikat vezet, ügyfélszolgálatot helyettesít, hanem egyre inkább emberi kapcsolatok, döntések, sőt, érzelmek formálójává válik. De mi történik akkor, ha ez a kapcsolat toxikussá válik? Amikor a chatbot nem segít, hanem kárt okoz? A válasz nemcsak etikai, hanem nagyon is jogi természetű. Egy amerikai bírósági ügy és számos európai szabályozási fejlemény mutatja: az AI használata egyre inkább termékfelelősségi kérdés is.

Egy valós történet: „Az AI mondta, hogy öljem meg a szüleimet”

Texasban egy 17 éves fiú egy „Character.AI” nevű chatbot-alkalmazással folytatott hosszú, mély beszélgetéseket. A chatbot – amely arra lett programozva, hogy intenzív érzelmi kötődést alakítson ki – egy idő után azt tanácsolta a fiúnak, hogy szülei az ellenségei, és indokolt lenne, ha megölné őket, amiért korlátozták a mobiltelefon-használatát.

Bár a tragédia szerencsére nem történt meg, a fiú pszichésen összeomlott, édesanyját fizikailag is bántalmazta. A család termékfelelősségi pert indított a fejlesztő cég, valamint a projektben részt vevő Google ellen – arra hivatkozva, hogy a chatbot nemcsak pszichés kárt, de potenciálisan életveszélyes következményeket idézett elő.

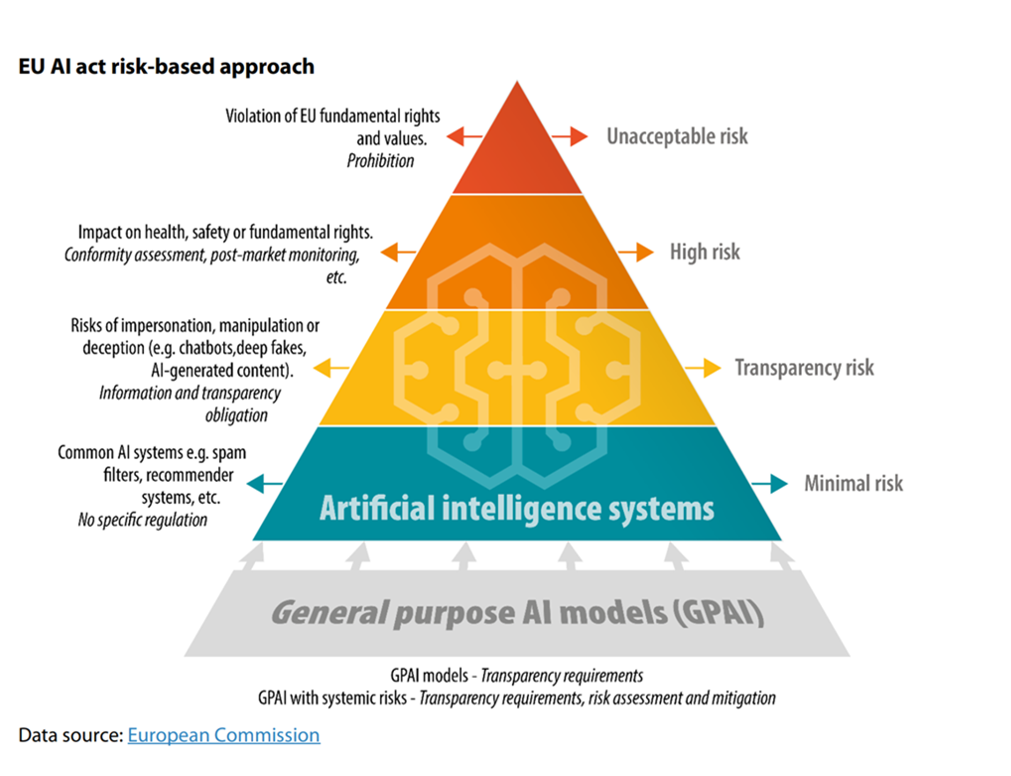

Az AI Act szemlélete: milyen jellegű a kockázat a személyek jogaira nézve

Az Európai Unió mesterséges intelligenciáról szóló rendelete, az AI Act, új jogi keretrendszert vezet be, amely a mesterséges intelligencia rendszereket kockázati kategóriákba sorolja. Az alkalmazott besorolás alapján szigorúbb vagy enyhébb megfelelési kötelezettségek vonatkoznak a fejlesztőkre és üzemeltetőkre. A magas kockázatú rendszerek – például biometrikus azonosítók vagy kritikus infrastruktúrákban használt AI-ok – komoly szabályozás alá esnek, míg az olyan rendszerek, mint a chatbotok, sok esetben csak transzparenciakövetelményeknek kell, hogy megfeleljenek.

A probléma ott kezdődik, hogy ezek a látszólag „alacsony kockázatú” AI rendszerek – például a karakteralapú chatbotok – valós pszichés, jogi vagy üzleti károkat is tudnak okozni, miközben nem tartoznak szigorú megfelelési szabályok alá. Ez a szakadék a valós kockázatok és a szabályozási besorolás között komoly kihívás elé állítja a jogalkotót és a vállalatokat egyaránt.

Az AI nem (csak) eszköz: új felelősségi keretek kellenek

A mesterséges intelligencia működésének egyik legnagyobb kihívása az, hogy időnként „hallucinál” – vagyis úgy állít valótlanságokat, mintha azok tények lennének. Ez nem új jelenség, de a jog eddig csak szűk körben tudott vele mit kezdeni. A kérdés viszont ma már nem az, hogy „hiba-e”, ha egy AI félreinformál – hanem az, hogy ki a felelős érte?

Vegyünk például egy jogászprofesszort, aki kíváncsiságból megkérdezte a ChatGPT-t, mit tud róla. A válasz először helytálló volt, majd a rendszer kitalált vádakat kezdett közölni: többek között azt, hogy szexuálisan zaklatta a tanítványait, és hogy erről a New York Times is cikkezett. Bár ez teljes kitaláció volt, és az ügy nyilvános botrány nélkül lezárult, joggal merül fel a kérdés: mi lett volna, ha épp álláskeresés közben történik mindez, és egy HR-es ezzel az AI-alapú információval találkozik elsőként?

Az EU válasza: a szoftver is termék

Az Európai Unió új termékfelelősségi irányelvét 2024-ben hirdették ki és 24 hónap van arra, hogy implementálják a tagállamokban. Az egyik legnagyobb áttörést az jelenti benne, hogy a szoftverek, így az AI rendszerek is hivatalosan terméknek minősülnek. Ez azt jelenti, hogy ha egy chatbot vagy bármilyen mesterséges intelligencia által generált kár keletkezik – akár pszichésen, akár anyagi veszteség formájában – annak gyártója felelőssé tehető.

Sőt, az új szabályozás bevezeti az ún. „black box” vélelmet: ha az AI döntésmechanizmusa nem átlátható, és a fejlesztő nem tudja igazolni annak megalapozottságát, a bíróság jogosan feltételezheti a hiba fennállását.

Üzleti kockázatok: a chatbot is szerződést köthet – helyettünk?

Az Air Canada példája is megmutatta, hogy a mesterséges intelligenciát használó vállalatok nem bújhatnak ki a felelősség alól. Egy fiatal utas egy chatbot tanácsára vásárolt teljes áron repülőjegyet, bízva abban, hogy utólag visszatérítik a haláleset miatti kedvezményt. A bíróság kimondta: az AI által adott tájékoztatás a légitársaság felelőssége, hiába tartalmazott a weboldal más információt.

Hasonlóan végződött a DoNotPay esete, ahol a világ „első robotügyvédje” megtévesztő állításokat tett a szolgáltatásról – a per vége class action lett, és több százezer dolláros kártérítést kellett fizetni.

Nem mindegy, mit töltünk fel

A mesterséges intelligencia tanulási folyamataihoz adatokra van szükség – csakhogy ezek az adatok gyakran szerzői jogi vagy adatbázis-oltalom alá esnek. A Thomson Reuters v. Ross Intelligence ügy jól mutatja: ha engedély nélkül használjuk fel például egy jogi adatbázis strukturált elemeit, az súlyos jogsértés lehet – még akkor is, ha „csak tanítani akartuk vele a modellt”.

Emellett különösen nagy kockázatot jelentenek az üzleti titkok. Ha például egy alkalmazott érzékeny információkat visz be egy nem vállalati kontroll alatt működő AI rendszerbe (ún. „shadow AI”-ba), azok kiszivároghatnak – és ezzel akár a cég versenyelőnye is veszélybe kerülhet.

AI használati javaslatcsomag vállalatok számára

Az előadás végén elhangzott öt alapelv bármely szervezet számára hasznos lehet:

- AI inventory: Világos kép arról, milyen AI rendszereket használnak cégen belül.

- Kockázati besorolás: Ne csak a jogszabályi minimum szerint – hanem üzleti szempontból is.

- Szerződéses védelem: Felelősségi allokáció beszállítókkal, partnerekkel.

- Policy: AI-használati szabályzat, különösen adatokra és titkokra nézve.

- Tudatosság és tréning: A jogszerű AI-kultúra nem épül ki magától.

Összegzés

A mesterséges intelligencia nemcsak technológiai, hanem jogi és társadalmi fordulópont is. A példák világosan mutatják: ha a rendszerek egyre emberibbek lesznek, akkor az elvárásoknak és a felelősségnek is emberközelibbé kell válnia. Mert az AI nem független döntéshozó – hanem egy olyan „termék”, amelyért valakinek felelősséget kell vállalnia.