Harc a láthatatlan fenyegetések ellen – Hogyan védi az AI-t az AI?

![]() Vilhelm Zsolt

Vilhelm Zsolt

![]() 2025.08.21

2025.08.21

A mesterséges intelligencia (MI) forradalma nem csupán a termelékenységet és az innovációt pörgeti fel – egy új, láthatatlan kiberfegyverkezési verseny közepén találjuk magunkat. A generatív AI, különösen a nagy nyelvi modellek (LLM-ek), mára a mindennapi élet és az üzleti folyamatok szerves része lett. Dokumentumok összefoglalása, kódgenerálás, ügyfélszolgálati chatbotok – ma már szinte minden szervezet használ valamilyen AI-megoldást, akár tud róla, akár nem.

A Palo Alto Networks három nem régiben bemutatott megoldása – AI Access Security, AI-SPM (Security Posture Management) és AI Runtime Security – kifejezetten ezekre a modern, AI-központú fenyegetésekre kínál védelmet. Ezek nem csupán detektálnak és figyelmeztetnek, hanem proaktívan akadályozzák meg az adatvesztést, a manipulációt és a kártékony műveleteket.

Az AI árnyoldala – amikor a technológia a támadók kezébe kerül

Az LLM-ek nyelvi kifinomultsága új szintre emelte a social engineering támadásokat. Egykor a magyart törve írt e-mail azonnal lebuktatta az adathalászt – ma már a mesterséges intelligencia tökéletes nyelvezetet és stílust képes produkálni, akár teljesen személyre szabva. Ez különösen veszélyes vállalati környezetben, ahol egyetlen megtévesztett felhasználó is kinyithatja a kaput a támadók előtt.

A támadói oldalon már megjelentek az úgynevezett „sötét” LLM-ek, mint például a WormGPT vagy az Evil Bart. Ezek kifejezetten kártékony kódok, támadási forgatókönyvek és exploit-leírások generálására vannak betanítva – ugyanazzal a hatékonysággal, mint a legitim modellek a jó oldalon.

A prompt injection is új frontot nyitott. A támadó úgy alakítja a bemenetet, hogy a modell saját beépített biztonsági korlátait kikerülve adjon ki tiltott információt vagy végezzen nem kívánatos műveletet. Ez lehet akár technikai jellegű (például autófeltörési útmutató) vagy manipulatív (hamis adatok beszúrása a válaszba).

A Palo Alto Networks szemlélete – három pillér az AI biztonságában

A Palo Alto Networks a kockázatokat három nagy területre bontja, és mindegyikre célzott technológiai választ ad. A cél nem csupán a támadások elhárítása, hanem a teljes AI-használati lánc átláthatóvá, kontrollálhatóvá és biztonságossá tétele.

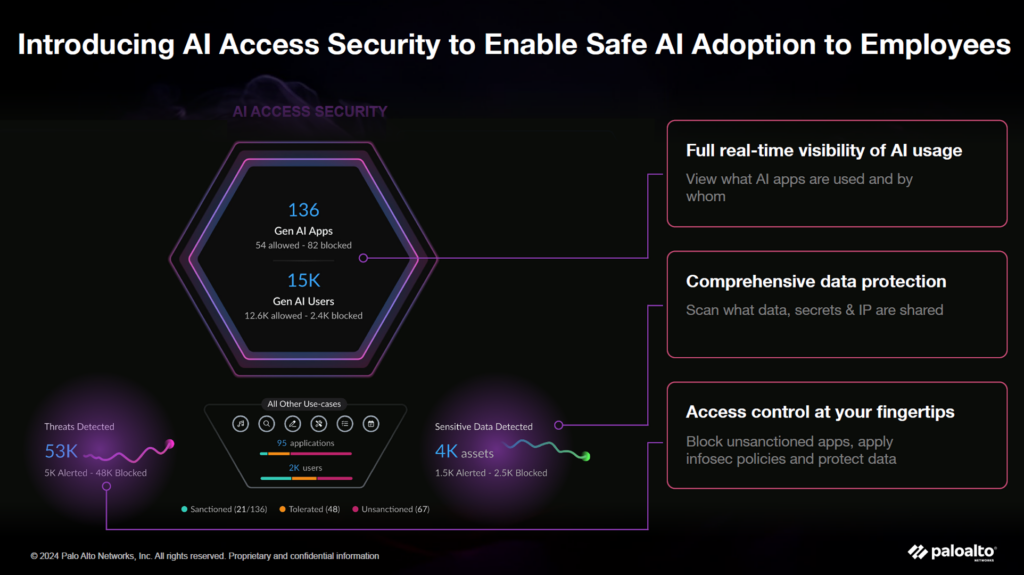

1. AI Access Security – Láthatóság és adatvédelem az AI-használatban

Az AI Access Security olyan, mint egy radar, amely minden vállalati AI-alkalmazást észlel – beleértve azokat is, amelyekről az IT osztály nem tud (shadow AI).

- Teljes vizibilitás: kategorizálja a használt AI-eszközöket – legyen szó chatbotokról, kódgenerátorokról, képgenerátorokról vagy videókészítő platformokról.

- Adatszűrés valós időben: a rendszer felismeri a szenzitív információkat (pl. személyi igazolványszám, bankkártyaadat) és blokkolja azok AI-modellekbe való továbbítását.

- Szabályalapú kontroll: a vállalat biztonsági irányelvei alapján engedélyezi vagy tiltja az egyes AI-alkalmazások használatát.

Ez a megoldás nemcsak a kockázatok csökkentését szolgálja, hanem jogi és megfelelőségi (compliance) szempontból is fontos: segít biztosítani, hogy az AI-használat megfeleljen az adatvédelmi előírásoknak és szerződéses vállalásoknak.

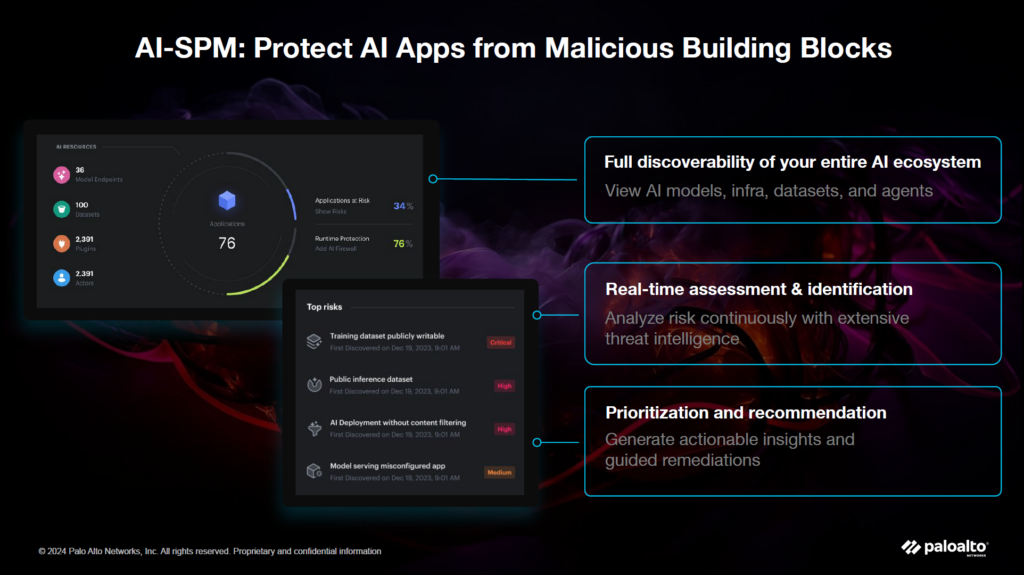

2. AI-SPM – Biztonsági helyzetkép az AI-ökoszisztémáról

Sokan úgy gondolnak egy AI-alkalmazásra, mint egyetlen LLM-re – pedig a valóság ennél sokkal összetettebb. Egy modern AI-megoldás mögött gyakran komplett infrastruktúra húzódik:

- hardver (GPU-k, CPU-k),

- konténerek és orchestration platformok,

- vektoradatbázisok,

- API-k és plugin-modulok,

- valós idejű adatforrások.

Az AI-SPM célja, hogy ezt az összetett ökoszisztémát teljes egészében feltérképezze és biztonsági szempontból értékelje.

- Komponensleltár: láthatóvá teszi az AI-rendszer minden elemét.

- Sérülékenység-elemzés: feltárja az infrastruktúra és az alkalmazás szintjén meglévő biztonsági réseket.

- Adatkapcsolatok feltérképezése: megmutatja, hogy az AI-alkalmazás milyen belső vagy külső adatforrásokhoz fér hozzá, és ezek mennyire biztonságosak.

- Kockázatpriorizálás: rangsorolja a fenyegetéseket, így a biztonsági csapat a legkritikusabb problémákkal kezdheti a javítást.

Ez a funkció különösen hasznos azoknak a vállalatoknak, amelyek saját AI-alkalmazást fejlesztenek vagy integrálnak harmadik fél szolgáltatásaiból.

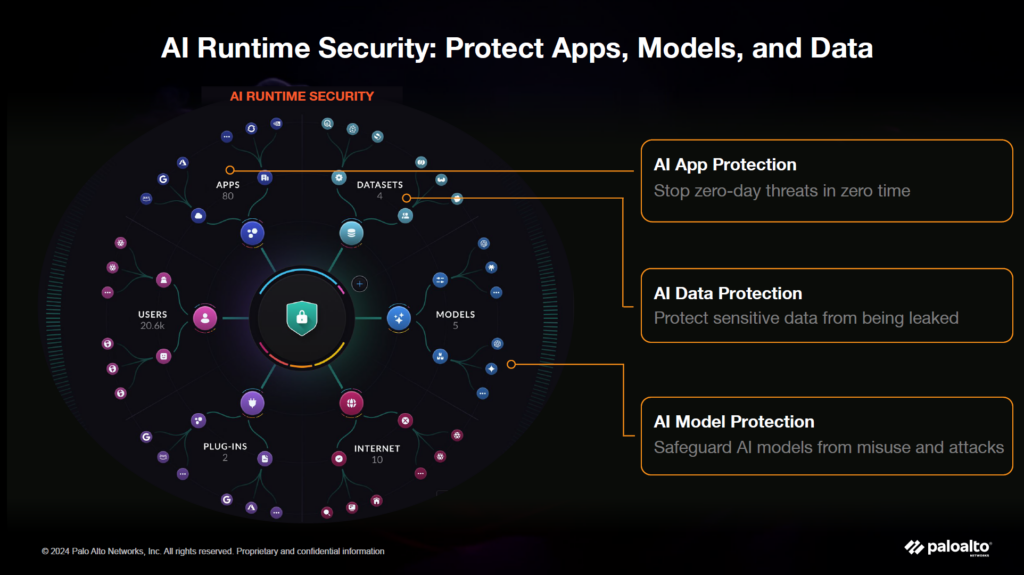

3. AI Runtime Security – Védelem a futásidőben történő támadások ellen

A támadások egy része nem a fejlesztési fázisban, hanem éles működés közben éri az AI-rendszert. Az AI Runtime Security egy speciálisan AI-környezetre optimalizált Palo Alto Networks tűzfal, amely:

- Prompt injection elleni védelem: blokkolja a manipulált kéréseket, amelyek a modell biztonsági korlátait próbálják kijátszani.

- Kimeneti (output) ellenőrzés: kiszűri a mérgezett adatot, a fals információt vagy a kártékony URL-t tartalmazó válaszokat.

- Konténer- és felhőbiztonság: képes kontrollálni a konténerizált AI-komponensek közötti hálózati kommunikációt, még felhőalapú környezetben is.

Ez a fajta futásidőbeli védelem kulcsfontosságú, mivel a támadók gyakran valós idejű manipulációkkal próbálnak kárt okozni.

OWASP Top 10 – most már az LLM-ekre szabva

Az OWASP hagyományos „Top 10” listája évek óta a webalkalmazások legfőbb biztonsági kockázatait rangsorolja. A generatív AI térnyerésével azonban megszületett az LLM OWASP Top 10 is, amely a nagy nyelvi modellek leggyakoribb sebezhetőségeit sorolja fel.

Nem meglepő, hogy a prompt injection vezeti a listát, de mellette olyan problémák is szerepelnek, mint az output-kezelési hibák vagy a jogosulatlan adat-hozzáférés. A Palo Alto Networks megoldásai – különösen az AI-SPM és az AI Runtime Security – több pontot is lefednek ebből a listából, így jelentősen csökkentve a támadási felületet.

Összegzés – AI az AI ellen

Az AI fejlesztése és integrálása ma már nem versenyelőny, hanem üzleti alapkövetelmény. A kiberbiztonság azonban nem maradhat le: a védelemnek ugyanolyan gyorsan kell fejlődnie, mint magának a támadási technológiának.

A Palo Alto Networks három új megoldása – AI Access Security, AI-SPM és AI Runtime Security – együtt egy olyan védelmi rendszert alkot, amely:

- teljes láthatóságot biztosít az AI-használatban,

- feltárja az AI-ökoszisztéma sérülékenységeit,

- és valós időben blokkolja a kártékony műveleteket.

A mesterséges intelligencia a jövő egyik legnagyobb lehetősége – és egyben legnagyobb kockázata is. A kérdés nem az, hogy használjuk-e, hanem az, hogy hogyan. Tudunk-e értéket teremteni vele és közben meg tudjuk-e védeni.